사이버보안 연구원들은 SAP AI Core 클라우드 기반 플랫폼에서 액세스 토큰과 고객 데이터를 확보하는 데 악용될 수 있는 예측형 인공지능(AI) 워크플로를 만들고 배포하는 데 사용되는 보안상의 단점을 발견했습니다.

5가지 취약점은 집합적으로 다음과 같이 명명되었습니다. SAPwned 클라우드 보안 회사 Wiz가 제공합니다.

보안 연구원 힐라이 벤-사손은 The Hacker News와 공유한 보고서에서 “우리가 발견한 취약점을 통해 공격자는 고객 데이터에 액세스하고 내부 아티팩트를 오염시킬 수 있었으며, 이는 관련 서비스와 다른 고객 환경으로 퍼질 수 있었습니다.”라고 밝혔습니다.

2024년 1월 25일에 책임 있는 공개를 한 후, SAP는 2024년 5월 15일에 해당 취약점을 해결했습니다.

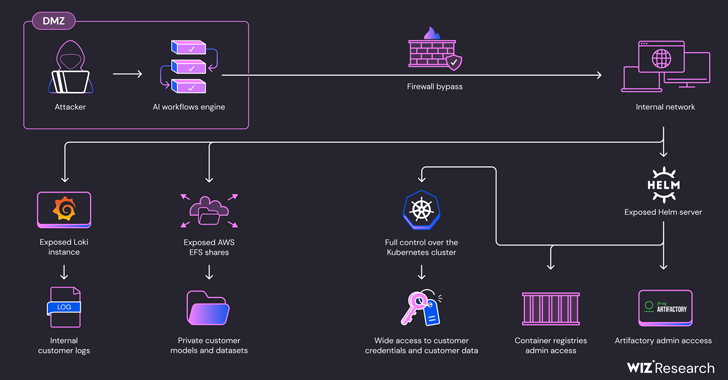

간단히 말해, 이러한 결함으로 인해 Amazon Web Services(AWS), Microsoft Azure, SAP HANA Cloud와 같은 클라우드 환경에서 고객의 개인 아티팩트와 자격 증명에 대한 무단 액세스가 가능해집니다.

또한 SAP 내부 컨테이너 레지스트리의 Docker 이미지, Google Container Registry의 SAP Docker 이미지, SAP 내부 Artifactory 서버에 호스팅된 아티팩트를 수정하는 데 사용될 수 있으며, 그 결과 SAP AI Core 서비스에 대한 공급망 공격이 발생할 수 있습니다.

게다가 Helm 패키지 관리자 서버가 읽기 및 쓰기 작업에 모두 노출되었다는 사실을 악용하여 SAP AI Core의 Kubernetes 클러스터에서 클러스터 관리자 권한을 얻는 데 이러한 액세스를 무기화할 수 있습니다.

“이 액세스 수준을 사용하면 공격자는 다른 고객의 Pod에 직접 액세스하여 모델, 데이터 세트, 코드와 같은 민감한 데이터를 훔칠 수 있습니다.” Ben-Sasson이 설명했습니다. “이 액세스를 통해 공격자는 고객의 Pod에 간섭하고, AI 데이터를 오염시키고, 모델의 추론을 조작할 수도 있습니다.”

위즈는 이 플랫폼이 적절한 격리 및 샌드박싱 메커니즘 없이도 악성 AI 모델과 훈련 절차를 실행할 수 있게 만들기 때문에 문제가 발생한다고 말했습니다.

“Hugging Face, Replicate, SAP AI Core와 같은 AI 서비스 제공업체의 최근 보안 결함은 테넌트 격리 및 세분화 구현의 심각한 취약성을 강조합니다.” Ben-Sasson이 The Hacker News에 말했습니다. “이러한 플랫폼을 사용하면 사용자가 공유 환경에서 신뢰할 수 없는 AI 모델과 교육 절차를 실행할 수 있어 악의적인 사용자가 다른 사용자의 데이터에 액세스할 수 있는 위험이 커집니다.”

“테넌트 격리 관행에 대한 방대한 경험이 있고 가상 머신과 같은 강력한 격리 기술을 사용하는 베테랑 클라우드 제공자와 달리, 이러한 새로운 서비스는 종종 이러한 지식이 부족하고 보안이 약한 컨테이너화에 의존합니다. 이는 테넌트 격리의 중요성에 대한 인식을 높이고 AI 서비스 산업이 환경을 강화하도록 밀어붙일 필요성을 강조합니다.”

그 결과, 위협 행위자는 AWS Elastic File System(EFS) 공유의 잘못된 구성을 악용하여 SAP AI Core에서 일반 AI 애플리케이션을 만들고, 네트워크 제한을 우회하고, Kubernetes Pod의 내부 네트워크를 조사하여 AWS 토큰을 얻고 고객 코드와 교육 데이터 세트에 액세스할 수 있습니다.

“사람들은 AI 모델이 본질적으로 코드라는 것을 알아야 합니다. 자체 인프라에서 AI 모델을 실행할 때 잠재적인 공급망 공격에 노출될 수 있습니다.”라고 Ben-Sasson은 말했습니다.

“신뢰할 수 있는 출처의 신뢰할 수 있는 모델만 실행하고 외부 모델과 민감한 인프라를 적절히 분리하세요. AI 서비스 공급자를 사용할 때는 테넌트 격리 아키텍처를 확인하고 모범 사례를 적용하는지 확인하는 것이 중요합니다.”

Netskope에 따르면, 생성적 AI를 사용하는 기업이 증가함에 따라 조직에서는 차단 제어, 데이터 유출 방지(DLP) 도구, 실시간 코칭 및 기타 메커니즘을 사용하여 위험을 완화하고 있습니다.

“규제된 데이터(조직이 보호할 법적 의무가 있는 데이터)는 생성 AI(genAI) 애플리케이션과 공유되는 민감한 데이터의 3분의 1 이상을 차지합니다. 이는 기업에 값비싼 데이터 침해의 잠재적 위험을 초래합니다.”라고 회사는 말했습니다.

또한 이들은 2024년 4월부터 AI와 게임에 초점을 맞춘 기관을 노리고 비밀 포럼에서 민감한 데이터를 훔치고 손상된 OpenAI API 키를 판매하는 것을 목표로 하는 NullBulge라는 새로운 사이버 범죄 위협 그룹의 등장을 추적하고 있습니다. 이들은 AI로부터 “전 세계의 아티스트를 보호”하는 해커 조직이라고 주장합니다.

SentinelOne 보안 연구원인 짐 월터는 “NullBulge는 GitHub과 Hugging Face의 공개적으로 사용 가능한 저장소에 있는 코드를 무기화하여 소프트웨어 공급망을 표적으로 삼고, 피해자가 악성 라이브러리를 가져오거나 게임 및 모델링 소프트웨어에서 사용하는 모드 팩을 통해 이를 실행하도록 유도합니다.”라고 말했습니다.

“이 그룹은 LockBit Black 빌더를 사용하여 빌드된 LockBit 페이로드를 전달하기 전에 AsyncRAT 및 XWorm과 같은 도구를 사용합니다. NullBulge와 같은 그룹은 정보 도난 감염의 상록 효과와 결합된 낮은 진입 장벽 랜섬웨어의 지속적인 위협을 나타냅니다.”